Как мошенники используют искусственный интеллект и нейронные сети для выманивания денег у простых людей. И как защитить себя от их тактики

seo2023-11-27T10:40:29+05:00Статьи о пока еще скромных возможностях искусственного интеллекта (ИИ) и нейронных сетей находят живой отклик у читателей. Неудивительно – ведь ИИ позволяет значительно облегчить труд и заработать деньги, чем тут же воспользовались мошенники.

Как мошенники используют нейронные сети

Нейронные сети могут облегчить людям выполнение определенных задач. Например, такие как ChatGPT и Notion AI могут написать любой текст, письмо, резюме, эссе и прочее. Для современной нейронки это не является проблемой. Кроме того, ChatGPT может легко писать программный код или даже редактировать код, написанный человеком. Эта функция не только облегчает жизнь программистам, но также используется мошенниками. Эксперты по кибербезопасности уже начали фиксировать случаи, когда код, написанный ИИ, использовался для фишинга.

Фишинг – это деятельность, направленная на кражу данных банковских карт и счетов в онлайн-банкинге, а также других данных о человеке с целью вымогательства или манипуляций. На «белых» (т. е. легальных) веб-сайтах и платежных сервисах эти данные защищены и безопасны для оплаты картой. Однако мошеннические сайты могут использовать украденные данные для опустошения вашего банковского счета. Поэтому с осторожностью относитесь к письмам и уведомлениям от банков или платежных систем, и не переходите по содержащимся в них ссылкам.

Схемы мошенничества с использованием искусственного интеллекта и нейронных сетей

Искусственный интеллект можно использовать как во благо, так и во зло, поэтому неудивительно, что эти так называемые «предприниматели» хотят облегчить себе жизнь с помощью тех же инструментов, которыми пользуемся мы.

Все знают, что есть нейронные сети, которые превращают предоставленный им текст в речь. Однако ИИ способны на большее — они могут не только озвучить предоставленный текст, но и произнести его голосом любого человека. И это действительно так, в чем вы сможете убедиться, посмотрев видеоролик ниже.

Это демонстрационное видео одной из компаний, разрабатывающей искусственные нейронные сети, включая искусственные голосовые нейронные сети, которые могут произносить любой текст любым голосом. Более того, нейронная сеть делает эту работу очень качественно и даже сохраняет индивидуальные характеристики человеческого голоса, такие как тембр, тон и прочие индивидуальные особенности.

Конечно, подобные инновации не лишены риска. Созданные таким образом «голосовые близнецы» могут быть использованы в различных целях. Например, их могут использовать для звонков жертвам, выдавая себя за родственников или друзей. Отличить голос от настоящего может быть очень сложно, особенно если телефонная линия плохая.

Преступники получают аудиообразцы голосов различными способами, например, записывая звук во время телефонных разговоров, используя видеозаписи в социальных сетях или записывая звук в общественных местах, например, в кафе.

Чтобы не попасть в такие ловушки, рекомендуется перезвонить абоненту и проверить, звонил ли он на самом деле, особенно если во время разговора вы услышали просьбу о чем-либо подозрительном, например, одолжить денег или сообщить коды безопасности карты.

Однако нынешние мошенники пошли еще дальше в использовании ИИ. Новейшие сервисы искусственного интеллекта теперь могут создавать не только звукового двойника, а также видео двойника. Мошенники создают видеоролики, в которых просят денег у знакомых, говорят или делают опасные вещи, чтобы шантажировать своих жертв. Такие видео, известные как «дипфейки», попали в интернет в прошлом году, и нетрудно представить, что будет в 2023 году, когда искусственный интеллект шагнул далеко вперед.

В качестве примера можно привести известного казахского блогера, утверждающего, что он «показывает» сайт, на котором можно заработать много денег. Однако видео оказалось фальшивым.

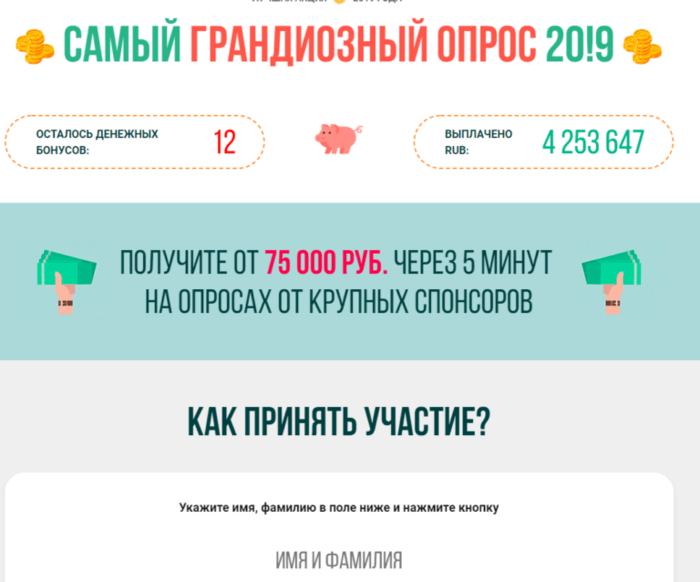

Существуют и другие способы мошенничества. Аферисты e-pay одними из первых использовали этот метод в Рунете для обработки жертв. Они использовали видеоролики, размещенные популярными знаменитостями в Instagram, для создания фальшивых видео, в которых «звезды» якобы призывали собеседника «пройти опрос и получить деньги».

Размещая эти фальшивые видео в своих рекламных объявлениях, мошенники способны привлечь большое количество людей, верящих своим кумирам. А жертвы, разумеется, никогда не получат никаких денег, а только потеряют средства на «оплату сборов, налогов и т. д.» и другие предлоги, которые мошенники e-pay используют, чтобы скрыть свою аферу.

«Самый грандиозный опрос» – это первый случай использования дипфейка в мошенничестве с e-pay.

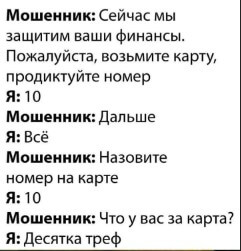

В целом, наши советы по борьбе с этими видами мошенничества просты. Если вы получили голосовое сообщение или кто-то из ваших знакомых связался с вами через мессенджер и вы чувствуете, что что-то не так, перезвоните ему позже и попросите повторить и уточнить свою просьбу. Если вы видите рекламу со знаменитостями знаменитости, в которой вас просят куда-то перейти, что-то пройти и «заработать денег», не спешите. Это может быть опасно для ваших финансов и душевного спокойствия.

Поэтому, дадим шуточный совет, который убережет ваши финансы в разговоре с мошенником:

Источник: Правдоруб.

Добавить комментарий

Для отправки комментария вам необходимо авторизоваться.